Право лица, ищущего работу, на объяснение при принятии решения с помощью автоматизированной обработки

Аннотация

Повсеместное использование технологий алгоритмического принятия решений и их внедрение работодателями и кадровыми агентствами для оптимизации поиска персонала в разы увеличивают вероятность дискриминации и необоснованного отказа в приеме на работу. В этой связи представляется необходимым закрепить в ТК РФ правила применения алгоритмических технологий при принятии решений с целью обеспечения реализации и защиты прав и законных интересов лиц, ищущих работу.

Ключевые слова

| Тип | Статья |

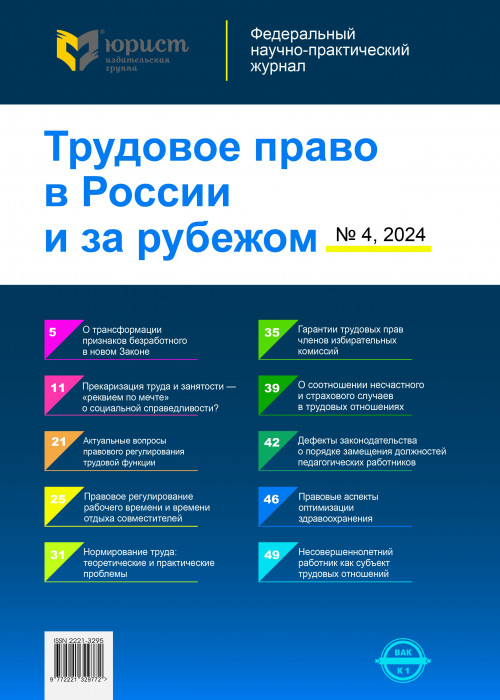

| Издание | Трудовое право в России и за рубежом № 04/2024 |

| Страницы | 8-11 |

| DOI | 10.18572/2221-3295-2024-4-8-11 |

Развитие технологий искусственного интеллекта (ИИ, алгоритмические системы, автоматизированные системы) помимо, безусловно, положительного эффекта для разных сфер жизни общества имеет обратную сторону, создающую угрозу для реализации прав человека. В литературе обращено внимание на то, что принятие решений (при помощи) ИИ может снизить уровень жизни человека, препятствуя ему в получении социальных благ, в том числе при устройстве на работу. Аналогичные предостережения можно увидеть в Руководстве по автоматизированному индивидуальному принятию решений и профилированию для целей Регламента (GDPR) 2016/679, согласно которому профилирование может увековечить существующие стереотипы и социальную сегрегацию. Связано это с выявленными фактами предвзятости, дискриминации, нарушения права на частную жизнь и защиту данных.

Право на труд особо выделено в контексте реализации принципа защиты прав и свобод человека в Национальной стратегии развития искусственного интеллекта на период до 2030 г. (далее — Стратегия). В результате работы алгоритмических систем доступ работника к труду может быть затруднен или вовсе заблокирован. Подобное происходит из-за слабого правового регулирования, а также отсутствия полного контроля за работой ИИ со стороны человека ввиду неисследованных аспектов работы ИИ, а также вызывающих тревогу фактов выхода из-под контроля человека и намеренного обмана со стороны запрограммированного ИИ, который должен быть честным.

Правовое регулирование принятия решений на основании автоматизированной обработки персональных данных в российском законодательстве характеризуется незрелостью и фрагментарностью, что дает возможность работодателям (операторам) практически свободно решать экономические и производственные задачи в ущерб правам и законным интересам лиц, ищущих работу, на доступ к труду и защите от дискриминации (ст. 64 ТК РФ, ч. 3 ст. 1 Конвенции МОТ № 111 от 25 июня 1958 г. «Относительно дискриминации в области труда и занятий»).

Одним из наиболее важных вопросов в исследуемой области, на наш взгляд, является фиксирование принципа прозрачности и права на объяснение, который получил закрепление в большинстве международных нормативных актов в сфере регулирования ИИ. В соответствии с проектом закона ЕС об ИИ принцип прозрачности обязателен для высокорискованных систем ИИ, которыми признаются, в том числе, используемые в сфере трудоустройства, управления работниками и доступа к самозанятости (например, программное обеспечение для сортировки резюме при приеме на работу). Предусмотрена обязанность поставщика обеспечить достаточную степень прозрачности работы системы ИИ с высоким уровнем риска (п. 2 ст. 1, п. 1 ст. 13): т.е. она должна проектироваться таким образом, чтобы гарантировать, что ее работа достаточно прозрачна, чтобы позволить интерпретировать выходные данные системы и использовать их надлежащим образом.